Skriv ett mejl utan att vidröra tangentbordet. Lägg en order och tryck ut en fraktetikett med viljan. Gränssnittet för att kontrollera maskiner eller apparater med ”hjärnan” har gjort entré och så här fungerar det.

På Code 2018, Rancho Palos Verdes, Kalifornien, står Adam Berenzweig, director på Research and Development vid CTRL-labs, och demonstrerar hur deras Machine Brain Interface fungerar. Det är en, som det heter på engelska, mind blowing demonstration.

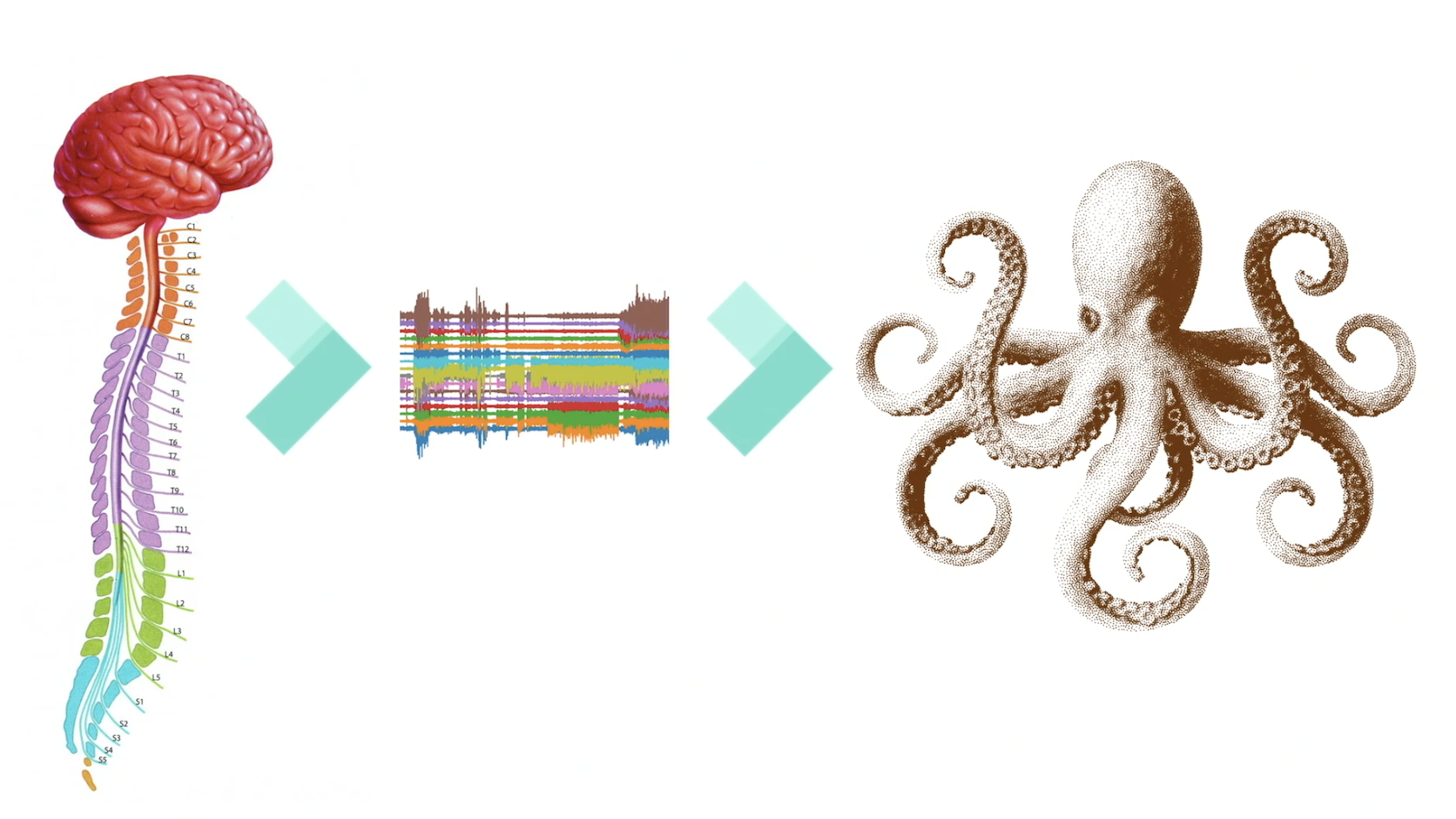

Inte bara för att tekniken – ett armband – gör det möjligt för dig och mig att interagera med en mobiltelefon utan att vare sig släppa händerna från ratten (om du kör bil), eller höja rösten (använda ett röstgränssnitt), utan också för att deras gränssnitt och API öppnar upp för den som skulle vilja testa hur det är att, likt en bläckfisk, ha åtta armar.

Och detta helt utan några medicinska ingrepp: varken inopererade nålar eller elektroder varsamt utplacerad på en nyrakad skalle.

Hur är det möjligt?

Läs också: Därför kommer du snart kunna få det du behöver utan att lägga en beställning

Att vidga den neurologiska bandbredden

- Hur kan vi minska avståndet mellan mänsklig input och mänsklig output?

Adam Berenzweig och hans kollegor på CTRL-labs påpekar att människans nervsystem tar in och bearbetar mängder av input hela dagarna med hjälp av alla sinnen. Vi gör detta blixtsnabbt. Men i motsatt riktning är vi relativt långsamma.

Människans förmåga att styra ”världen” motoriskt är långsam eftersom våra rörelser och muskler är långsamma. Vi är heller inte Blixt Gordon när vi styr en enhet med rösten. Därför tar det tid för oss att interagera med våra apparater.

- Vår ”bandbredd” är smalare på output-sidan, menar Adam Berenzweig. Vilket känns logiskt och kanske lite poetiskt: Från tanke till handling är steget ofta långt. Åtminstone så länge man måste sträcka sig efter en mus, swipa på en skärm eller luta sig över ett kontrollbord.

För att överbrygga denna "paradox" har CTRL-labs frågat sig:

Hur kan vi avlägsna behovet av en mellanliggande kontrollenhet, i form av musplatta, mikrofon, pekskärm etcetera, och därmed öppna upp för direktinteraktion med den digitala världen?

Annorlunda formulerat:

Hur kan vi avkoda den elektriska aktivitet som hjärnbarken sänder ut till musklerna? Det vill säga: Hur kan vi avkoda nervsystemets faktiska informationsvaluta för att tillämpa dess intention i realtid?

Eller för att prata ren svenska:

Hur kan vi styra saker och ting med hjärnan?

Läs också: Machine learning, digital logistik och hjälp till behövande

Gränssnittet som förstår dina intentioner

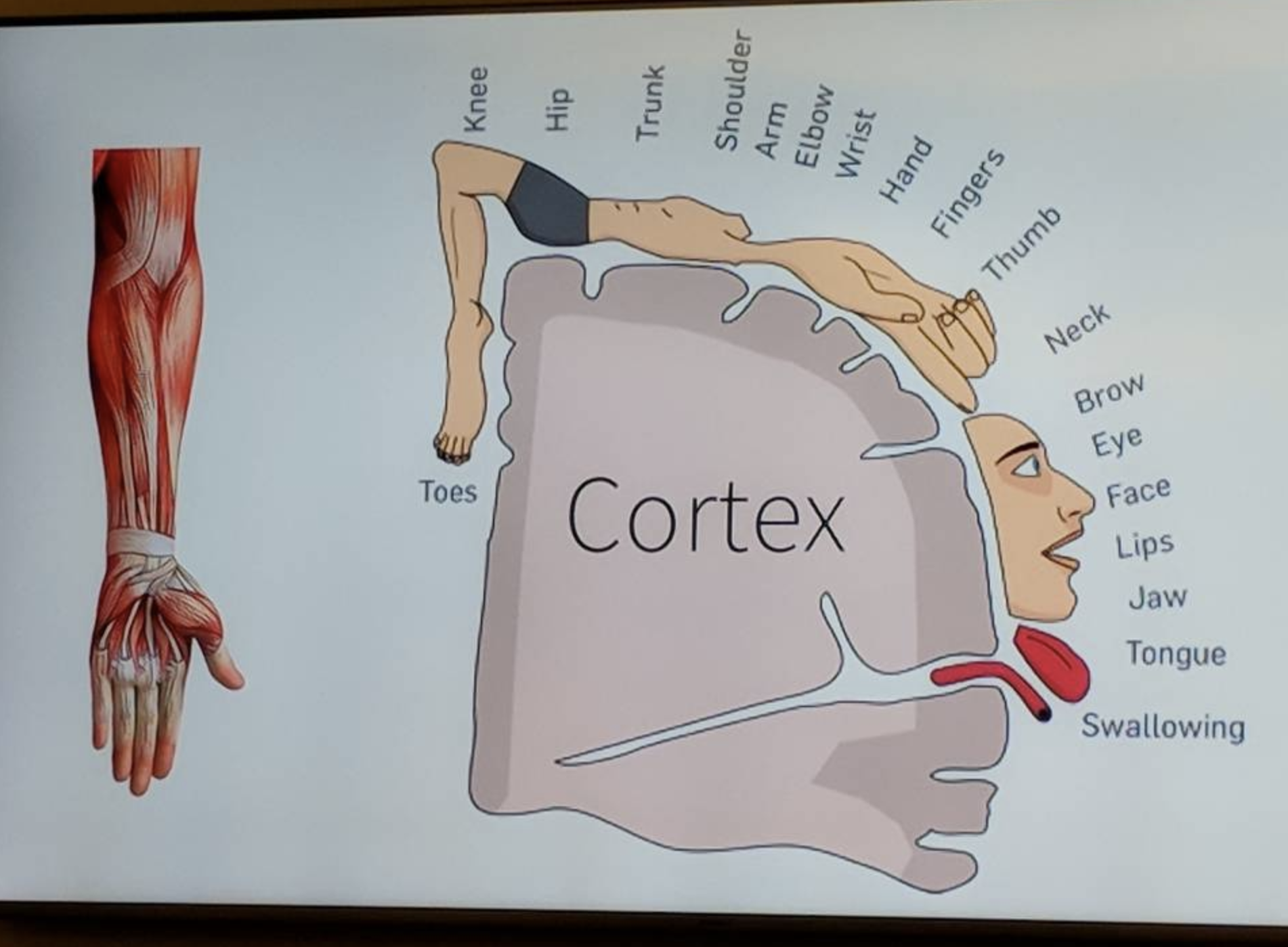

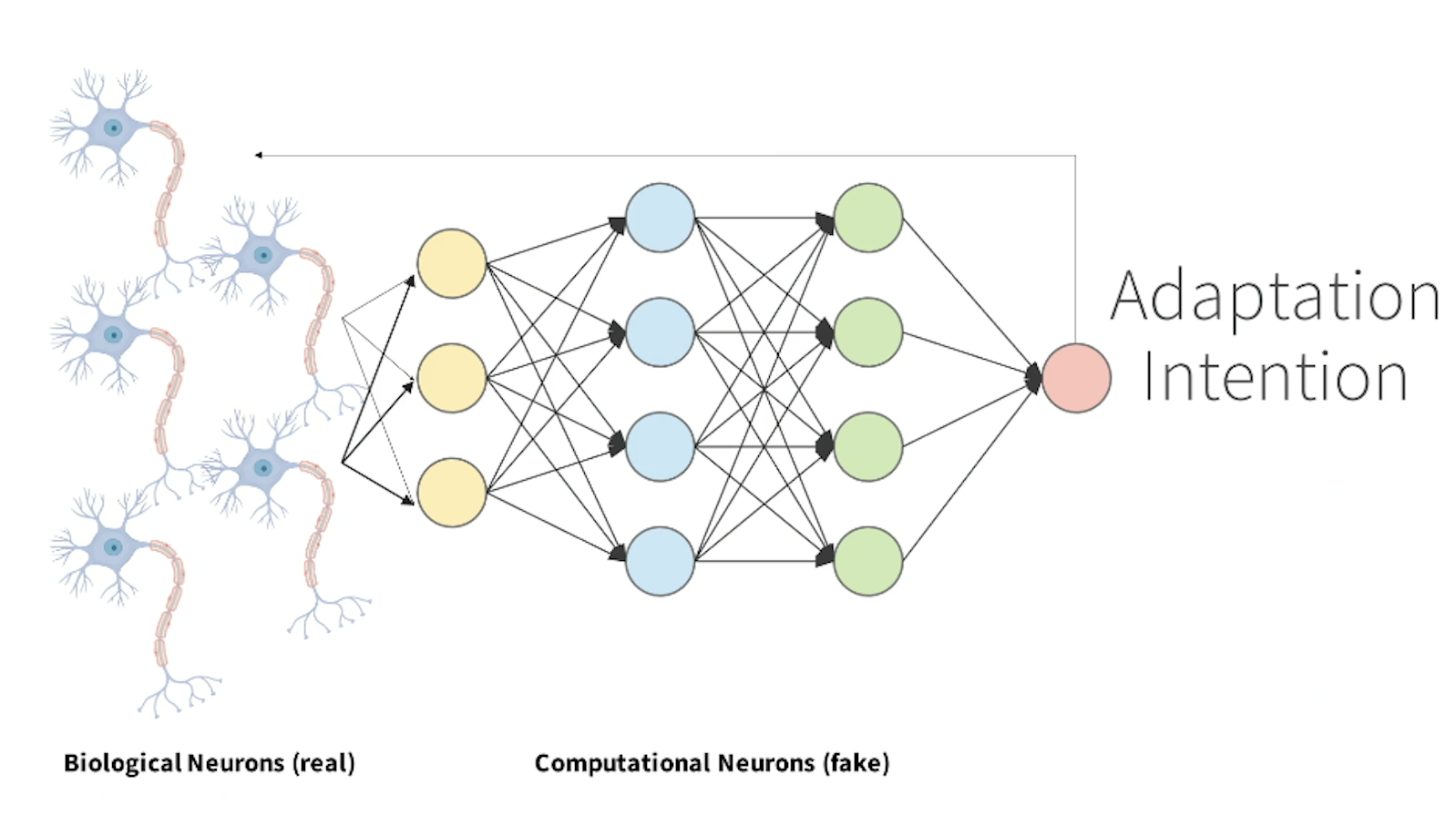

Adam Berenzweig visar ovanstående bild och förklarar hur de först var tvungna att bestämma sig för vilka neuroner eller nervsignaler de ville avkoda. På CTRL-labs noterade de att munnen och handen är de mest intensiva områdena i den motoriska hjärnbarken.

Handen kniper dock förstaplatsen: Hjärnan är processad för att avsätta mest kraft och energi för att kontrollera och manipulera denna del av kroppen. De signaler som går ner till handen (eller någon annan kroppsdel) är dessutom tydligare och trovärdigare i sina instruktioner än de signaler som går att mäta på huvudet. När signalerna har kommit ner till armen och handen är dess intentioner lättare att läsa av.

Därför valde man att fokusera på de neurala signaler som flödar ut till handen. ”Att fokusera på” betyder, bland annat, att avkoda individuella nervsignaler i armen i realtid: alltså medans de är på väg till handen med information om vad handen ska göra. ”Att avkoda” betyder att förstå signalernas intentioner.

Hur då?

Se också: This is how it looks when voice control integrates with a system for delivery management

Muskelkontroll och neurokontroll

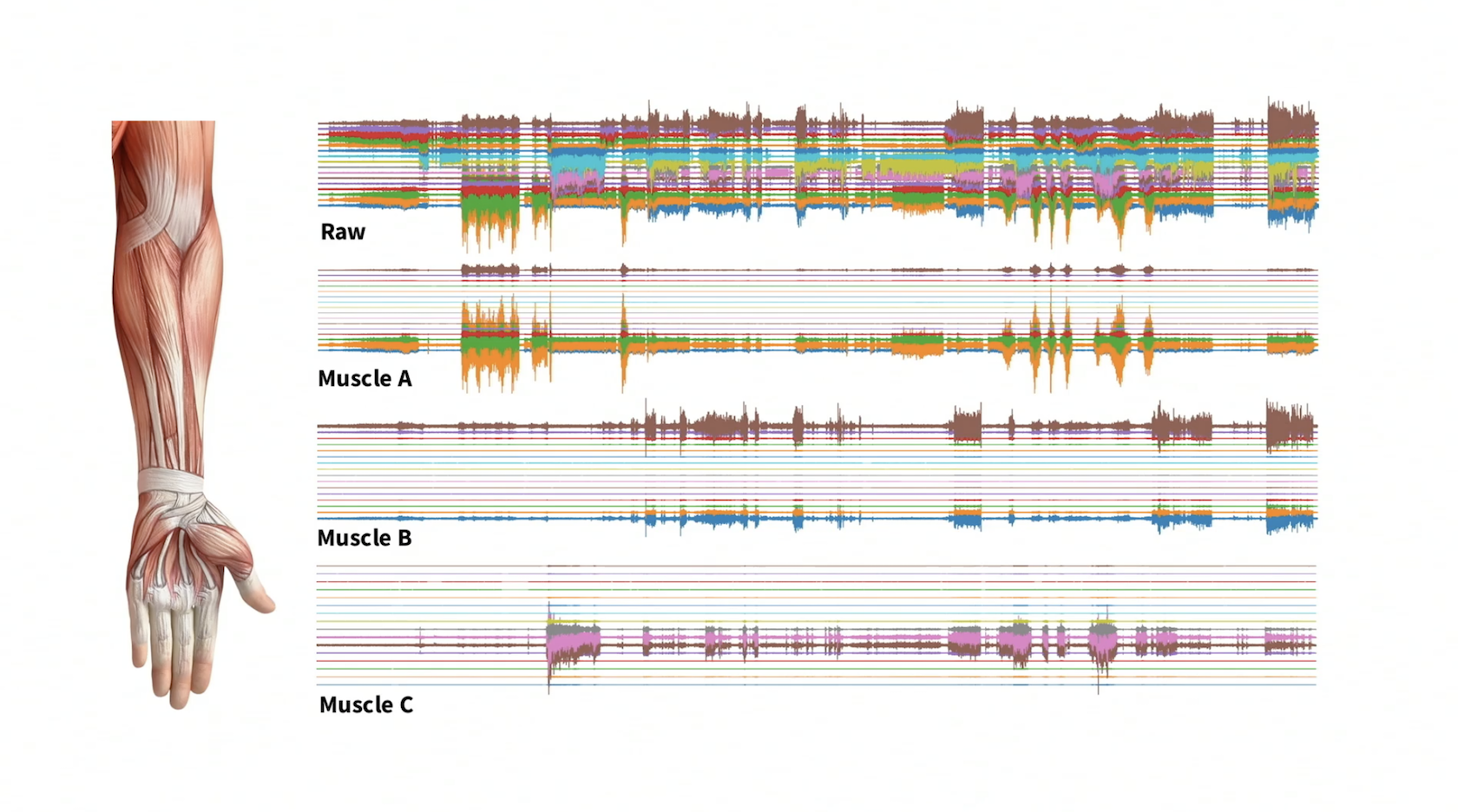

CTRL-labs avkodar nervsignalerna med hjälp av en samling sensorer och teknik som heter Surface Electromyography, förkortas Surface EMG.

Myocontrol betyder muskelkontroll.

Med hjälp av Surface EMG kan de ta en komplex hjärnsignal/nervsignal och liksom översätta den. Exakt hur är svårt att förklara, men tekniken heter dekonvolution och bygger på en avancerad matematisk databehandlingsteknik som återger olika signaler.

Med Surface EMG förstår de vad var och en av de 14 musklerna i armen, på väg ut till handen försöker göra, både när en människa rör sig på ett naturligt sätt men också när människan rör sig på ett mer onaturligt sätt. Det sistnämnda syftar på saker som att skriva på ett tangentbord, klicka på en mus eller liknande.

Lite förenklat kan man säga att när systemet förstår hur signalerna ska tolkas försvinner behovet av ett tangentbord, en mus, en pekskärm, etcetera.

Men vad förstår systemet egentligen, och hur?

Ettorna och nollorna i nervsystemet

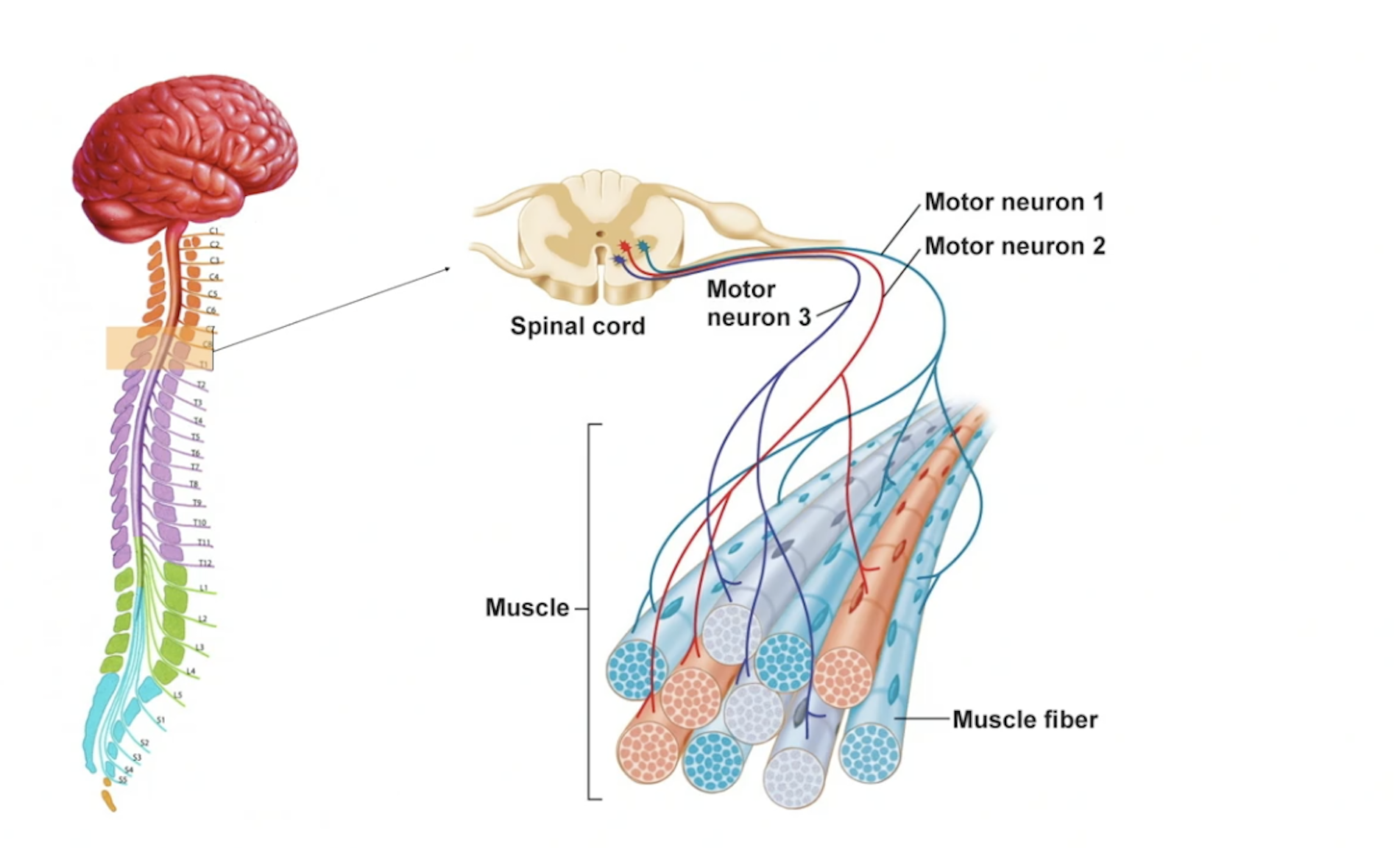

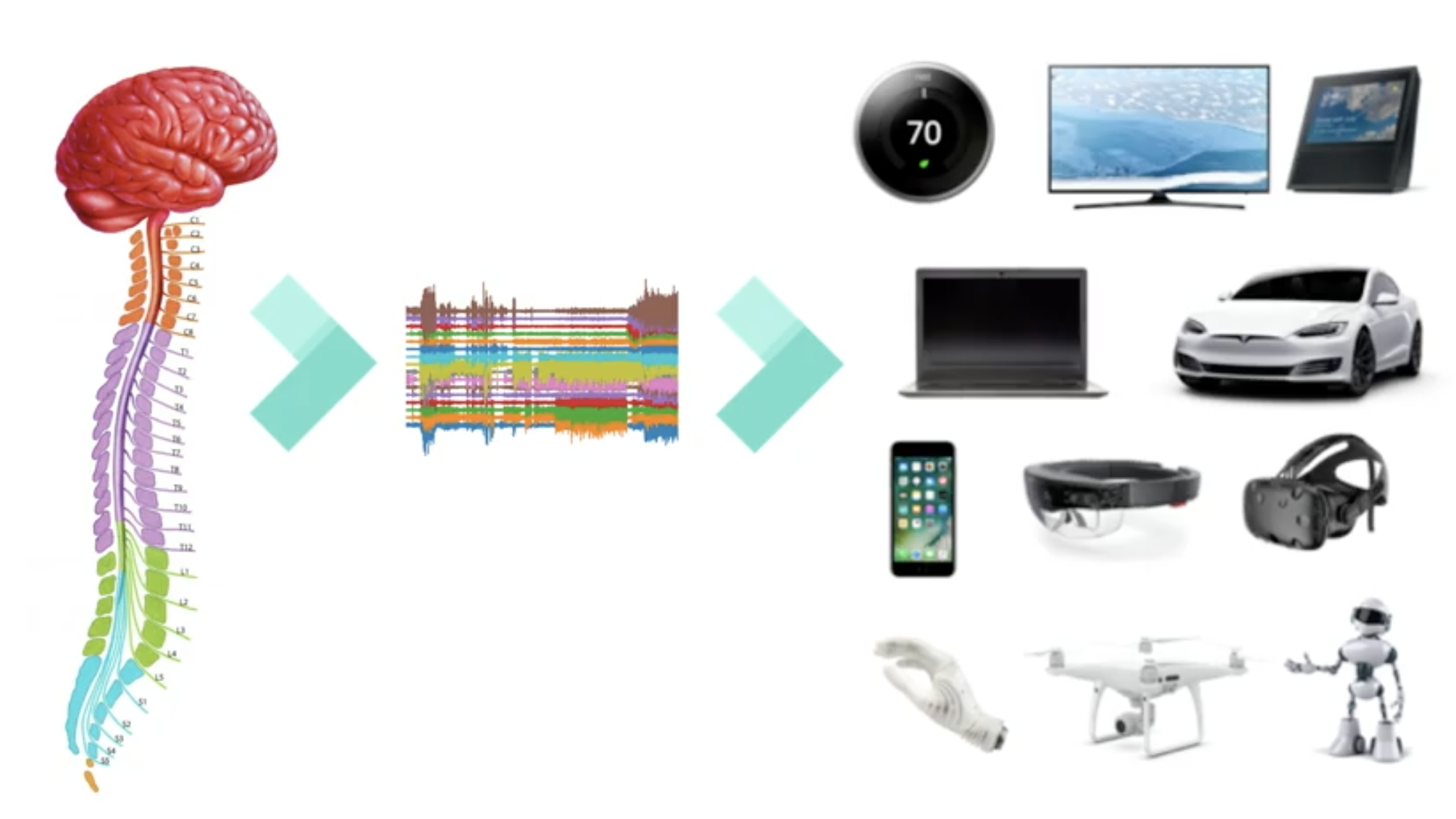

Hjärnan har övre motor-neuroner i hjärnbarken. De ”synapsar ner” signaler till de lägre motor-neuronerna som finns i din ryggrad. Dessa skickar i sin tur ut leveransen med nervsignaler till musklerna genom de långa axonen. Vid muskeln frisläpper sändningen neurotransmittorer ut ”på” muskeln och på så vis styrs individuella muskelfibrer: det vill säga den individuella muskelfibern slås på och av.

Bilden ovan visar tre kluster av muskelfiber som styrs av var sin motor-neuron.

CTRL-labs förstår vilken information dessa aktionsneuroner kommer med till musklerna. De kan med sin teknik avkoda ettorna och nollorna i nervsystemets informationsflöde. De har med andra ord nått kärnan i information som hjärnan skickar ut till musklerna:

Att förstå den här information är som att gräva fram en kommunikationssignal som är minst lika kraftfull som rösten eller det talade ordet, menar Adam Berensweig.

Medan rösten utvecklades för att sprida information från en hjärna till en annan, har aktionsneuronerna/motor-neuronerna utvecklats för att sprida information från hjärnan till (exempelvis) handen. Men det är alltså först med CTRL-labs arbete som dessa aktionsneuroner har gjorts tillgängliga och användbara "utanför" handen.

Innan CTRL-labs lyckades ta fram en teknik för att läsa av aktions-neuroner fanns det alltså inget sätt att se, förstå, återge och sätta dem i handling utanför handen/kroppsdelen. Eller som Adam Berensweig säger i en intervju:

”It’s as if there were no microphones and we dint’ have any ability to record and look at sound”.

Att gifta ihop biologiska neuroner med syntetiska neuroner

Den grundläggande frågan i den här teknikutveckling har alltså varit:

Hur kan vi styra saker och ting med hjärnan.

Svaret på denna fråga blev:

Genom att gifta samman biologiska neuroner med syntetiska neuroner, det vill säga ”computational neurons”.

För att komma hit, det vill säga till en punkt där de kunde omvandla människans ”nakna intentioner” eller ”blotta vilja” till avkodade signaler som apparaterna kan förstå var de tvungna att använda kodning, maskininlärning och neurovetenskap.

Och så en dag. Simsalabim: mindcontrol/neurocontrol.

Och det mest fantastiska är inte att du –nu – med ett armband på underarmen kan kontrollera din mobiltelefon utan att lägga ett endaste finger på den. Utan att du också, samtidigt – och detta är förunderligt – kan anpassa dessa intentioner och viljeyttringar i ett samspel med maskinen, som en slags maskin-inlärnings-dans mellan människa och apparat. Du kan själv välja vad du vill att dina signaler från hjärnan ska kunna göra i eller genom enheten du vill styra.

Ett kraftfullt API mellan hjärna och maskin

CTRL-labs har lyckats minimera avståndet mellan hjärna och maskin genom att sikta in sig på nervsystemets ”lågt hängande frukt”. Det vill säga den ström av signaler som flödar ut från hjärnan och ryggmärgen för att kontrollera kroppens muskler. Det visade sig vara ett lika pragmatiskt som strategiskt genialt drag. (Mer om detta i slutet av artikeln.)

Resultatet har blivit ett kraftfullt API mellan hjärna och valfri maskin.

Armband på underarmen

Den prototyp som möjliggör tekniken CTRL-labs tagit fram består bland annat av ett armband som du kan se på Adams Berenzweigs arm i filmen högst upp. Armbandet fångar hans intentioner genom att avkoda hans biologiska neuroner med hjälp av digitala neuroner.

Men hur använder man armbandet?

Hur lär du dig att använda gränssnittet?

Svaret på den frågan hänger lite på vilken applikation du vill använda. Enligt Adams Berenzweigs tar en del applikationer bara några minuter innan användaren fattar galoppen.

För att "fatta galoppen" får användaren en liten inkörningssession där den specifika användarens output och maskinens "intake" lär känna varandra.

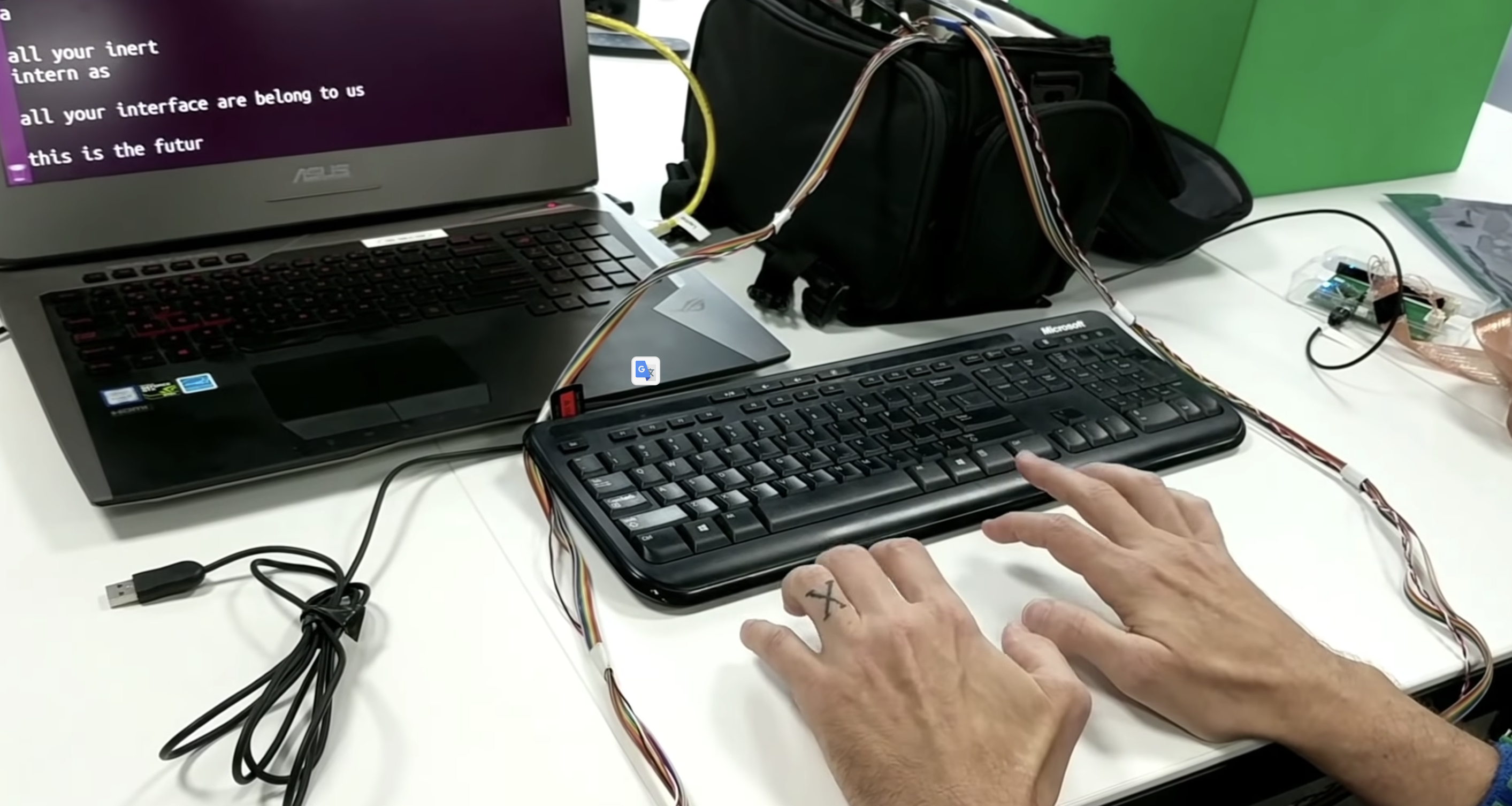

Andra applikationer eller utmaningar kommer kräva en längre inlärningsperiod. Som när användaren vill göra något mer eller något annat än att efterlikna de handlingar eller rörelser "man" redan gör idag. Med "rörelser man redan gör idag" syftar CTRL-labs, till exempel, på att skriva på ett tangentbord. Att efterlikna detta går att göra genom att skriva i luften, vilket demonstreras i denna film.

Eller att spela Asteroids på en mobiltelefon utan att röra handen.

CTRL-labs tror att armbandet kommer ha potential att bli det nya normala i hur vi interagerar med världen/maskinerna. Samtidigt som behovet att lära sig att skriva på ett "osynligt" tangentbord kommer försvinna. Istället kommer vi kunna utveckla andra sätt att "skriva".

Riktigt intressant blir det därför, kanske, först när vi med tiden kan börja utforska vad CTRL-labs MBI kan lära oss om vår hjärna och dess förmåga.

En av företagets rådgivare, John Krakauer (professor I neurologi) säger att den mänskliga handen är ett mycket användbart verktyg men undrar om vår hjärna kan hantera betydligt mer komplexa verktyg än handen:

Den konstanta rörelsen är huvudsaken

Det finns en uppdelning inom neurovetenskapen där den ena "sidan" fokuserar på vad som försiggår inne i hjärnan och den andra "sidan" fokuserar på hjärnans output.

CTRL-labs hör till den senare kategorin.

En ”frontfigur” i denna inriktning är neurologen Daniel Wolpert vars forskning visar att människan har en hjärna ENBART för att producera komplexa och adaptiva rörelser. Det är enbart genom rörelsen du kan påverka din omgivning och interagerar med världen.

På CTRL-labs vill man gärna framhålla att deras sida är den mer pragmatiska skolan. En rörelse som passar dem som tycker att default inte bör vara en värld där tekniken "äger" människan: Och därför fokuserar på hur de kan ge människor mer kontroll över tekniken här och nu, nu nu!

Vad man än tycker om detta förhållningssätt står det klart att du redan i år kommer kunna köpa ett CTRL-labs-kit. Det ser onekligen ut som om teamet med fokus på rörelse och hjärnans output vunnit något slags race i jakten på ett gränssnitt som ger oss mind over machine-control

Vilket ur en supply chain-nörds synvinkel känns lite som att se sitt eget lag vinna. För en entreprenör inom digital logistik och transportadministration rådet det nämligen ingen tvekan om att det är flödena och den konstanta rörelsen som är, ja, huvudsaken.

Läs också: Logistik är det nya svarta när paketen digitaliseras

--- --- ---

Behöver du en fungerande leveransstrategi som maximerar dina kunders upplevelse av, och lojalitet för, din e-handel? Ladda ner e-boken som ger dig en steg-för-steg guidning. Yes, helt gratis.